Stable Diffusion est un système d’IA (intelligence artificielle) open-source devenu public le 22 août 2022. Il est capable de créer des images et des œuvres d’art réalistes à partir d’une description en langage naturel. Cette IA peut être utilisée comme outil de création d’images, d’inspiration artistique ou d’art textuel et fonctionne sur presque toutes les cartes graphiques grand public !

Les origines

Stable Diffusion est l’idée d’Emad Mostaque, un ancien gestionnaire de fonds spéculatifs basé à Londres. Son objectif était de mettre à la portée du plus grand nombre les nouvelles applications de l’apprentissage machine par le biais de sa société, Stability AI. Bien que la Stable Diffusion soit révolutionnaire, d’autres modèles quasi similaires ont également été présentés cette année par d’autres entreprises (notamment DALL-E 2, Midjourney, Craiyon, etc.).

Comment fonctionne Stable Diffusion ?

Cette année, les modèles de diffusion (un type d’IA) ont fait d’immenses progrès, mais alors comment fonctionne une IA ?

Tout d’abord, une IA est un ensemble d’algorithmes et de données qui ont pour mission de résoudre un problème spécifique. L’IA Stable Diffusion a été entraînée en lui donnant un sous-ensemble de 5 milliards d’images, avec des descriptions attachées à chacune. Le programme a compris par lui-même les différents composants des images et a ensuite pu apprendre à recréer ce qu’il avait vu.

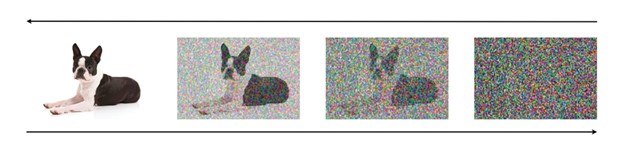

Elle produit des images grâce à un processus de corruption inversé qui synthétise les données à partir du bruit pur en le débruitant progressivement jusqu’à ce qu’un échantillon propre soit produit.

Les limites

Comme évoqué précédemment, Stable Diffusion a été entraînée sur des milliards d’images provenant du web. Cela sous-entend, que toutes les images ne peuvent être libres de droit.

De plus cette IA, va certainement être amenée à remplacer certains services et emplois dans les années à venir (exemple : banques d’images payantes). Elle peut être utilisée dans la production d’image, action actuellement réalisée par l’Homme.

Et après ?

La prochaine étape dans la recherche sur les modèles de diffusion est peut-être la vidéo. En effet, Google et Meta l’ont déjà initié, avec les modèles (encore non disponibles au public) Imagen Video et Make-a-video. Ces modèles se basent sur le même principe que Stable Diffusion, tout en étant optimisés pour réaliser de courtes vidéos (similaires au gifs) sans son.

Comment l’exécuter ?

Le moyen le plus simple de tester cette IA est de se rendre sur Dream Studio (200 générations gratuites, login requis) ou le site officiel de Stability.ai.

Mais si vous avez un GPU Nvidia avec 4 GB ou plus de VRAM et un peu de détermination, vous pouvez l’exécuter directement sur votre PC pour obtenir des générations illimitées. La plus populaire des interfaces développées par la communauté open-source est l’interface web d’AUTOMATIC1111. Elle est disponible ici sur GitHub. Vous aurez besoin d’installer Python 3.10, Git et le checkpoint du modèle sur Hugging Face.

Cet article vous a donné envie d’en savoir plus sur AIS ?

Découvrez notre site internet !

Article écrit par Jules – AIS